2024年10月12日に、SMILEVIDEO(at 阿佐ヶ谷DRIFT)というイベントでオーディオビジュアルライブをやってみました。

今後同じようなことをやろうと思った人や自分のために、技術的なノウハウや心構えなどを記録しておきます。

背景

SMILEVIDEOは簡単に言うとニコニコ動画をテーマにしたクラブイベントです。

自分は昔ニコニコ動画で音MADを作ってたのがきっかけで音楽制作を始めました。会場は映像出力が可能だったのと、オファーを頂いてから開催日までの2ヶ月ほど暇だったので、「オーディオビジュアルMADライブ」をやってみようと思い、やってみました。この頃Intel MacからApple Sillicon Macに変えたばかりで、ベンチマークノリで久々にTouchDesignerを触ってみたらサクサク動いて楽しかったので取り入れてと思った、というのもあります。

作品のアティチュード

マジでノウハウには全然関係ないので、ここは興味なかったら読み飛ばしてください。。

今回の核となる「TouchDesigner」と「音MAD」それぞれを取り巻く環境に対する自分のアティチュードを簡単に述べようと思います。

私のとても偏った見解になってしまいますが、TouchDesignerを使っていることを公言している作品はバキバキにクールな作品が多いと思います。逆にバキバキにクールな作品を狙わずともなっちゃいがちな気もします。触ってみての実感ですが、テックいビジュアルを作りやすいし、チュートリアルもそういう感じのが多いなと思いました。「クール」とか「テックい」って何だ定義しなさいと言われると言葉にしづらいのですが、Youtubeで「TouchDesigner Visual」などと検索してもらうと出てくるようなビジュアルの傾向を勝手にそう言っています。私はいかんせん直球のクールさに自信がないというか、今まで熱い気持ちで真面目に冷笑をやってきたと思ってるので、直球のクールさから逸れてTouchDesignerを使ってみようと思いました。

次に音MADの話。音MADって多分Aviutlがめちゃくちゃ主流で、他にAfterEffectsとかVegasとかPowerDirectorとかもいたりすると思うんですが、TouchDesignerを使って音MAD作ってると公言してる人をまだ見たことありませんでした。音MAD業界にもTouchDesignerが広まったら、何ならジェネラティブ音MADの流れとかできてきたらおもろいのにな〜とか思いました。

音MADには色々スタイルがあるんですが、近年よく見るのはバチバチにAviutlとかを使いこなしプロ同然の編集技術を盛り込んで構成した小気味のいい、ビジュアル的にもクオリティが高い音MAD。あるいは、逆に粗々しい編集を自覚的に取り込んだりメタにメタを重ねたハイコンテクストな音MADとかもドナルド関連でよく見る気がします。何にせよ情報量がめちゃくちゃ多いです。3秒でも目を逸らしたら、もう一回巻き戻して見なきゃという気持ちになります。基本的に数分で終わる映像だからこの情報量が成立するんだと思います。今回はクラブで40分のライブです、情報量を詰め込みすぎると絶対しんどいと思ったので、MADをやりつつもクラブVJレベルまで情報量を抑えようと心がけました。できてたかわかりませんが……。

そういうことなどを念頭に置きながらやりました。誰もやってへん音MADかつ誰もやってへんオーディオビジュアルパフォーマンスをやりたい、ということですね。それが良いことなのかは知りませんが……。

使った機材・ソフトウェア

Macbook Air 2024 M3 13inch 24GB

Ableton Live 12

TouchDesigner (Build 2023.11880)

Blender 4.2

KORG nano KONTROL Studio(MIDIコントローラ)

iD14(Audio I/F, ループバック可能かつ3ch以上の出力があることが重要)

その他映像編集ソフト(Premiere使いました)

ライブ構成

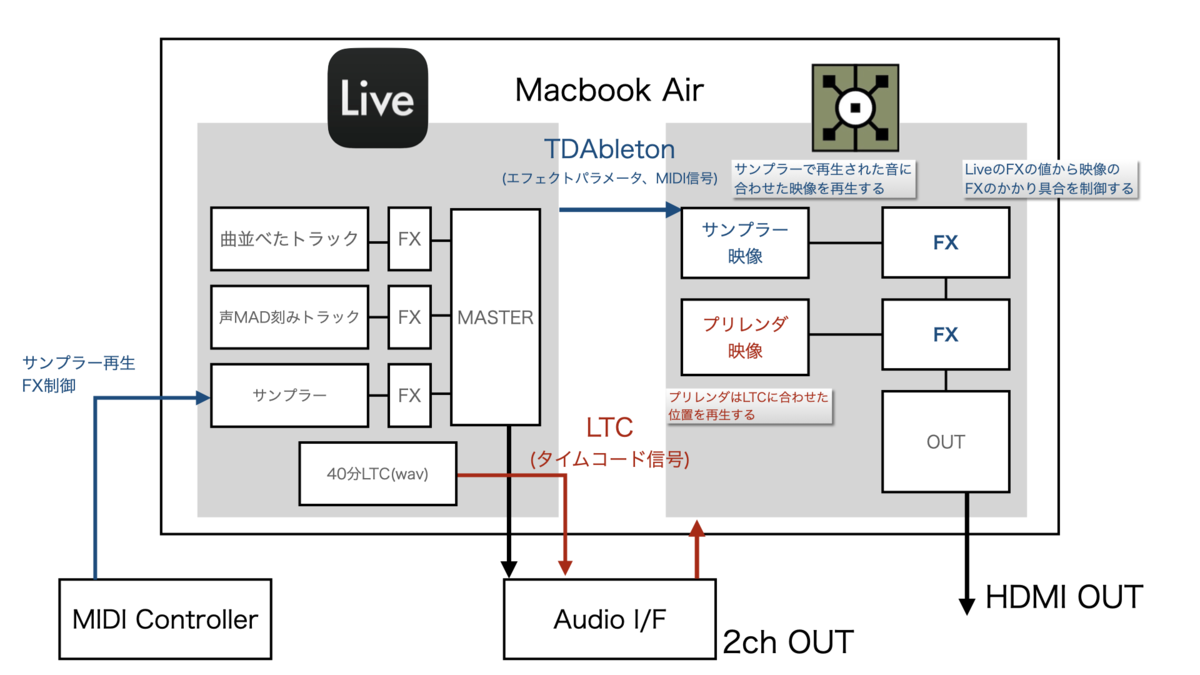

図の通りです。(わかる?)

まず荷物を多くしたくなかったのでMacbook Air一台で音声と映像をやることにしました。新しくPC買い足す金ももう無いし。。。

音はLiveから出します。40分ぶん曲を繋ぎながら並べたトラックを1つ*1、修造とか外山恒一とかいわゆる「音MAD素材」を刻んで並べたトラックを1つ、MIDIコントローラでボタン叩いたら音が鳴るサンプラートラックを1つ、そしてTDの映像とLiveの音声の同期を取るためのLTCトラックが一つ。LTCについては次の項で解説します。

映像は、40分のプリレンダ映像をまず用意しました。1280x720。画質は大して良くないですが、MADだし小箱でのプロジェクタ投影なのでヨシとしました。TouchDesigner、Premiere、Blenderを駆使して作りました。この映像を、Liveから送られてくるLTCを用いて音と同期させながら再生します。

TDAbletonを用いてエフェクトのパラメータやMIDIコントローラの値をLiveから受け取ります。これを使って、事前に用意したサンプラー用映像をサンプラーが鳴るタイミングに合わせて再生したり、ブラーなどのエフェクトをLiveのリバーブなどのエフェクトの強さに合わせてかけたりします。

なんとなく60fpsでやりたかったので60fpsで映像を準備しました。エフェクトはブラー、Bloom、JPEG風にガビガビになるやつ、Replace、などを使った4種類ほど用意しましたが、全部ONにした状態でも60fpsをキープできてました。わりとシンプルなので、エフェクトのリッチさ、映像の解像度次第ではfps下がるでしょう。

上の動画ではプリレンダ部分だけを載せています、撮り直すのめんどくさいのでまたもしリアルタイムでやる機会があればということで。

TIPS

プリレンダ映像と音の同期について

この記事で最も意味のある部分はおそらくここでしょう。ここを書くためにこの記事を書いたとも言えます。

やってみるとわかるのですが、TDから再生する40分のプリレンダ映像と、Liveから再生する40分の音をピッタリ同期させるのは意外にも厄介です。

参考になるスレッドがあるので貼っておきます。

実装の仕方は色々あるでしょうが、大きく分けると「TDAbleton」を利用する方法と、SMPTEタイムコード、特に音声信号でタイムコードをやりとりできるLTC(Linear Timecode)を利用する方法があると言えます。

最初はTDAbletonを用いる方法でやってみましたが失敗しました。TDAbletonでは、Liveのロケータの位置や、現在の再生位置を取得することができます。ロケータの位置をビデオの長さに合わせて、現在の再生位置をビデオのフレーム位置にマッピングする処理をしてみましたが、これは数分程度の動画だと成立したのですが、40分レベルだと何故か全然合わなくなってしまいました。何に原因があるのか突き止めたかったのですが、時間切れのため諦めました。

本番ではLTCによる同期を行いました。LiveからLTCの音をAudio I/Fの余ってるチャネルに送り、そのチャネルの音をI/Fのループバック機能でTDのAudio Device In CHOPに流します。これをLTC In CHOPに接続すると再生中のフレーム値(total_frames)が得られます。このフレーム値をMovie File InのIndexにCHOP Referenceするだけです。数フレームの遅れが発生するので、Constant CHOPの値を足してオフセットもできるようにしておきます。条件によってまちまちですが、9〜10フレームほど正方向に補正するとピッタリ合いました。

問題はLTCの信号をどう生成するかです。サクッとやるならClipSMPTEというM4Lがあります。ワープマーカーやテンポの変更にも対応してくれるそうで良さそうです。使ってないので分かりませんが……

私の場合は60fpsでやりたかったのですが、ClipSMPTEは30fpsまででした。LTCを生成してくれるWebサイトなんかもあるのですが、それも30fpsまででした。あまり詳しくないのですが、そもそもSMPTEはアナログテレビ録画システム向けに開発されたもので、30fpsで動作するものを対象にしていたそうです。従来規格SMPTE ST12-1 & ST12-2では30フレーム60フィールドまでしか規定されていないとのこと。*2 SMPTE ST12-3で最大960fpsをカバーするようになったそうです。

TDでは上スレッドで言われている通り60fpsをサポートしているようです。(上スレッドではST12-1 & ST12-2は60fpsが上限でこれをサポートしてるんだろうと言っている、よく分からない)LTC Out CHOPを使うと60fpsのLTCを生成することも可能でした。ちょっとめんどくさいのですが、40分のLTCをExport Movieで.movに書き出しました(Liveはmovも読み込めるので)。それなりに待つのがダルいですね。何かいい方法あれば教えてほしいです。

正確には39分ほどですが60fpsのLTCをアップしておきます。使いたい人いたら勝手に使ってください。うるさいので気をつけてください。

https://pianoid.net/timecodeman.mov

Live上ではこのトラックを配置して、再生するだけです。当たり前ですがタイムワープには対応しておりません、ワープを切って使ってください。

動画の形式

最初はファイルがでかいのが嫌で無神経にH.264/mp4で書き出してたのですが、特にDonald Ikedaパートがガビガビすぎたのでやめました。Youtubeにアップしてる動画はh.264にしたやつなのでガビガビです。粒子が細かいやつはどうしてもh.264と相性が悪いです。

最終的にApple ProResで書き出しました。ProResにもHQとかLTとかありますが、422 LTを使いました。どうせ1280x720だからいいやという感じです。それでも25GBぐらいあったと思います。

TouchDesignerで作った色んな素材をPremiereでコンポジットするという形でプリレンダ映像を作ってたのですが、場合によってはアルファチャネル付きで素材を書き出したいこともあります。なんでかTDのExport Movieではアルファチャネル付きのProResが書き出せなさそうだったので、NotchLCというのを使いました。Hapと同じノリで使えます。逆再生したい動画素材とかは、mp4は全然ダメなのでNotchLCを使うといいと思います。

安定したライブのために

最終的に1つのtoeだけで動かすことにしましたが、堅牢性を求めるなら刻みTDなどやった方がいいと思います。今回のケースでは刻まないほうが都合が良かったので結局刻みませんでした。

あとは以下のブログやQiitaの内容が参考になりました。特に「必要な時だけオペレータをcookする」は必須テクニックだと思います。

幸い今回のライブでトラブルはありませんでしたが、音が止まったり映像が消えたりしても、やっちまった感を出さないのは大事やと思います。アッとか言わず冷静に対処しましょう。こういう演出ですよ感で乗り切るのが大事やと思います。

制作手記

8月

8月5日にニコニコが復活してくれたので素材集めができるようになってよかったです。復活しなかったらちょっとヤバかったですね、いやYoutubeがあるから大丈夫か?

まずは音MADの音を作りつつ(時には曲ごと作りつつ)、並行してTouchDesignerも勉強がてら触ってました。どれぐらいジェネラティブにやってどれぐらいプリレンダでやるのかはまだ決めてませんでした。ただ、Macbook Air一台で音と映像をやるし、ミュージシャンとして音がブチってほしくはないので、まぁある程度はプリレンダになるだろうなと思いながら作ってました。結果的にほぼプリレンダになりました……。

TouchDesignerでVJやるなら、ジェネラティブにリアルタイムで音と合わせて映像を生成するのが一番美味しいのかもしれませんが、Apple SilliconとはいえMacbook air一台ですので。。バチバチにパフォーマンスチューニングすればどうにかなるかもしれませんが、音もやるということや自分の技術力を鑑みて、時間が足らなくなりそうな予感がしたので、大部分をプリレンダにする安全策を取りました。とはいえプリレンダもプリレンダでそれなりに大変なことはあります。

DJ風に曲を繋げていくのが普段のライブの仕方なので、映像もセクションごとに分けて短い映像素材を作るためのパッチをたくさん作ってました。一つの巨大なパッチを根気強く作るより、細かいパッチを色々作るのが飽き性の自分には向いてるみたいですね。

9月

絶対映像でめっちゃ時間使うだろうなと思ってたので、9月の中盤ぐらいには40分のMAD音源を完成させました。同時に作り溜めてた映像素材を、Premiere使いながらコンポジットしていきました。

どうしても時間が足りなくて、完全にPremiereだけで構成したパートも結構あります。無理に全部TDで作っても良くなるとは限らないし、40分尺だと手を抜くパートもないと見てる側も疲れると思います。

Liveのビデオ編集機能もかなり役立ちました。音に合わせてバンバカとカットアップするのはPremiereではかなり苦労する作業です、Liveはそれがめっちゃやりやすいです。

TDAbletonでLiveのステムの波形とかMIDI信号とかをTDに送って、Record CHOPで記録して、音に同期する映像をレンダリングしたりとかもよくやりました。修造パートとか特にそんな感じです。

坂東英二や生主の声などが収録されてるCDを買ったりしていました。美しいと思います。痛いニコ厨だった中学生の頃の思い出が蘇って、当時投稿した誰にも見せたくない動画とか見たりして、人生はペーソスだなと、哀愁感に浸る今日この頃です。

さっき聴いたけどすごすぎる pic.twitter.com/lFSqvNNEFs

— ピアノ男 (@pianoid) 2024年9月3日

10月

ほどほどに苦しみながら1週間ぐらい前に40分のプリレンダを完成させました。そこから急いで音・映像同期システムやリアルタイムパフォーマンスシステムを組んだりしてました。短期間で最低限のものはできちゃうのがTDのいいところだと思います。

今回のシステムはPENIS(Piaman Entertainment Nerd Intelligence System)と名付けました。PENISに興味がある方いましたら、是非連絡しないでください。

ライブ当日

HDMIケーブルの長さが足りないことに出番直前で気づいて転換に少し時間をとってしまったなどはありましたが、大きなトラブルはなくライブできました。みなさんいい反応をしてくれたのでよかったです。

参考にした本

リンクは改訂二版ですが改訂版のほう買いました。買ったばかりなのに改訂二版が出てくやしい!

映像ど素人なので、読んでみるかと思って途中まで読みました。富野作品を正直見たことがないですが。アニメや映画みたいなコンテを描くタイプの映像向けの話が中心なので、VJの参考に全てがなるわけではないですが、勉強なりました。

最近の個人的なテーマで窓です。YKKのパートなんかモロに影響出てますね。ニコニコとかYoutube見るのって窓から遠い景色を眺めてるようなもんですからね、ノウハウには全然関係ないですが面白いです。

さいごに

2ヶ月まるまる、仕事以外の時間をこれに費やしたので苦しかったですが、やってよかったと思います。TDを扱う能力もそこそこ伸びた気がします。

でもこの先MADは作らないと思います。一介のMAD作者としての集大成ということで、再上演はアリかもしれませんが新規でMADをやらせないようお願いします!自分で勝手にやっときながら何やって話ですが!

今、もうMADみたいな混沌さ・トバし具合ってトレンドすぎるので自分がやらなくてもいい気がするし、ニコニコ時代のコンテンツをノスタルジー的に消費しつづける作風にもなりたくないと思うので、今後は真面目に真面目な映像を作っていけたらと思います。

*1:2トラックだが1グループにしたので1つとする

*2:https://www.jstage.jst.go.jp/article/itetr/40.17/0/40.17_5/_pdf/-char/ja